近日,我院几何计算与智能媒体技术研究团队在计算机视觉领域顶级会议上取得创新成果,一篇论文被CVPR2023会议录用,一支参赛队伍在CVPR 2023 Workshop移动智能摄影与成像竞赛(MIPI)上夺冠。

由我院王祎副教授、樊鑫教授与RuiliWang(新西兰梅西大学)、何祥健(宁波诺丁汉大学)等合作完成的论文“Pixels, Regions, and Objects: Multiple Enhancement for Salient Object Detection”提出了一种新颖的多重增强网络(MENet)来模拟人类从图像的像素、区域和对象的角度反复逐渐增强对复杂目标的认知的能力,解决了现有大多数显着性目标检测(SOD)方法从像素的角度解释图像并使用简单的端到端训练方法,导致复杂场景中目标的边界不完整和模糊的问题。MENet采用双分支解码器结构,通过迭代交替聚合高级和低级梯度边界特征和自适应内部区域特征,并在提出的多级混合损失监督下完成精准显著性目标分割任务。六个具有挑战性的基准库的综合评估表明MENet取得了最先进结果。论文相关代码和模型下载链接:https://github.com/yiwangtz/MENet

我院博士研究生刘宇擎、贾棋副教授联合中科院自动化所、小米公司组成的参赛队伍,在CVPR 2023 Workshop移动智能摄影与成像竞赛(MIPI)中“RGBW数据联合重马赛克(Remosaic)、去噪”和“RGBW数据联合融合(Fusion)、去噪”两个赛道上取得冠军。

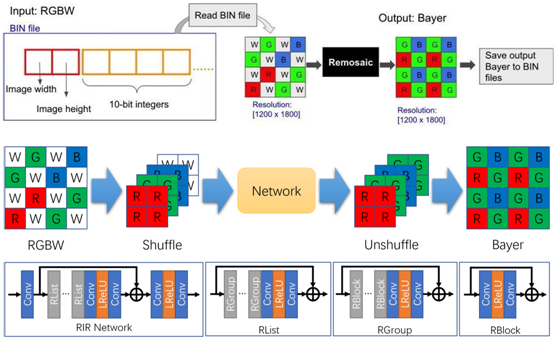

其中,“RGBW数据联合重马赛克、去噪”赛道旨在将RGBW 传感器捕获的RAW数据转换为相同分辨率的Bayer格式,以便进行标准的图像信号处理(ISP)操作。参赛队伍针对该任务提出了一种基于级联残差模块的神经网络同时进行Remosaic和去噪,通过通道重排列提高网络对RAW数据的处理能力。

图1. RGBW数据联合重马赛克、去噪方案

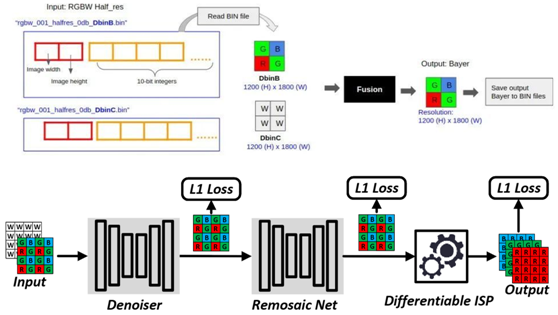

“RGBW数据联合融合、去噪” 赛道旨在将RGBW 传感器捕获的RAW数据转换为Bayer格式,通过融合RGB数据和W数据,提高Bayer格式的数据质量。参赛队伍针对该任务提出了一种端到端的去噪和数据融合神经网络,解耦去噪和数据融合过程,并利用可微分ISP来进一步提高恢复图像的质量。

图2. RGBW联合融合、去噪方案

据悉,CVPR是计算机视觉领域最顶级会议。根据谷歌2022学术影响力榜单:CVPR总榜第4(Nature第1,NEJM第2,Science第3),H5-index: 389,在计算机学科所有期刊/会议中排名第1。本届CVPR有效投稿 9155 篇,收录2360 篇,接收率为 25.78 %。

国际信息与软件学院几何计算与智能媒体技术研究团队依托于辽宁省泛在网络与服务软件重点实验室,研究课题包括机器学习、深度学习、计算机视觉、多媒体技术、优化方法等当前最前沿的领域。近年来在IEEE TPAMI、TIP、TNNLS、TMM、NeurIPS、IJCAI、AAAI、CVPR、ECCV、ACM MM等人工智能、多媒体技术等多方领域的重要期刊及会议上发表论文达100余篇。近一年来针对可学习优化的理论及应用研究已发表顶级会议和期刊(包括NeurIPS, AAAI, IJCAI, ACM MM, TIP, TNNLS等)论文30余篇。

责任编辑:潘树孟